La necesaria reflexión ética en el desarrollo de Inteligencia Artificial

Cómo adelantarse a los impactos negativos que podría producir la Inteligencia Artificial (IA) fue el foco de la investigación que expuso en el ciclo de Conferencias del Instituto de Éticas Aplicadas UC la académica Claudia López, experta en la interacción persona-computador (HCI), la computación social y la IA centrada en personas. En octubre, durante el […]

Cómo adelantarse a los impactos negativos que podría producir la Inteligencia Artificial (IA) fue el foco de la investigación que expuso en el ciclo de Conferencias del Instituto de Éticas Aplicadas UC la académica Claudia López, experta en la interacción persona-computador (HCI), la computación social y la IA centrada en personas.

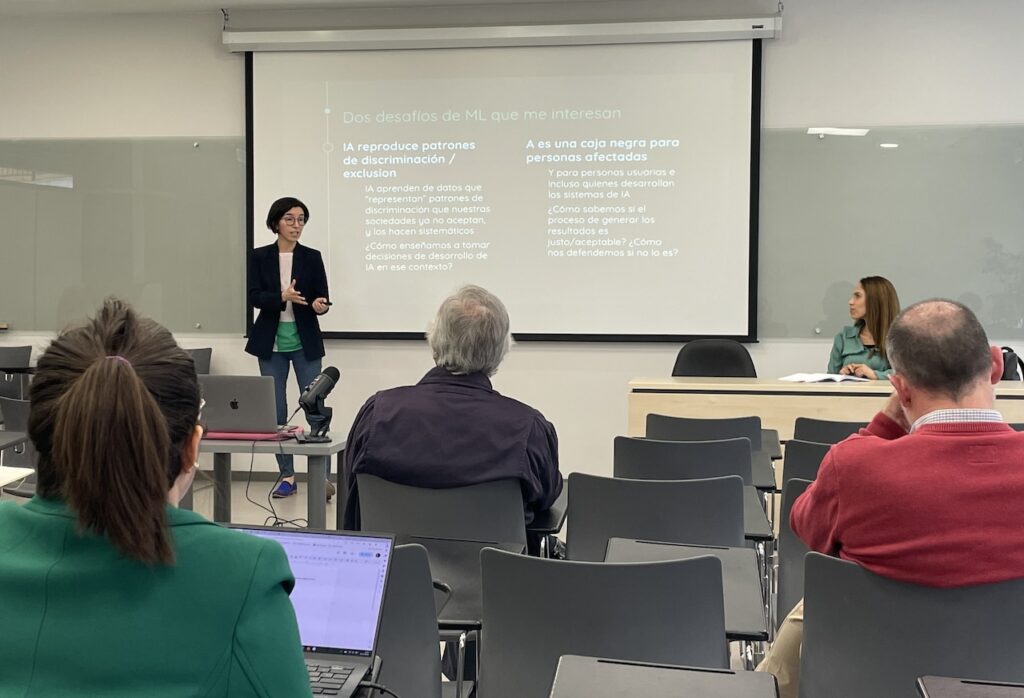

En octubre, durante el ciclo de Conferencias en Éticas Aplicadas 2023 organizado por el Instituto de Éticas Aplicadas UC, la académica Claudia López, del Departamento de Informática de la Universidad Técnica Federico Santa María (UTFSM), dio cuenta de su trabajo de investigación bajo el título “Explorando metodologías centradas en personas para abordar desafíos éticos de la Inteligencia Artificial (IA)”.

En su presentación, la docente destacó dos, de los diversos desafíos éticos en esta área, en que está enfocada de manera de tratar de entender los sesgos que implican. En primer lugar, afirmó López, la IA reproduce patrones de discriminación y/o exclusión, porque las IA aprenden de datos que “representan” patrones de discriminación del pasado, que nuestras sociedades ya no aceptan, y los reiteran de modo sistemático.

Para la académica, si la IA aprende de estos datos históricos, también va a aprender de los sesgos y los reproducirá a gran escala, por lo cual será más difícil asociarles responsabilidad a las personas y habrá que empezar a vincularle esta responsabilidad a las máquinas, lo que implica varios problemas adicionales.

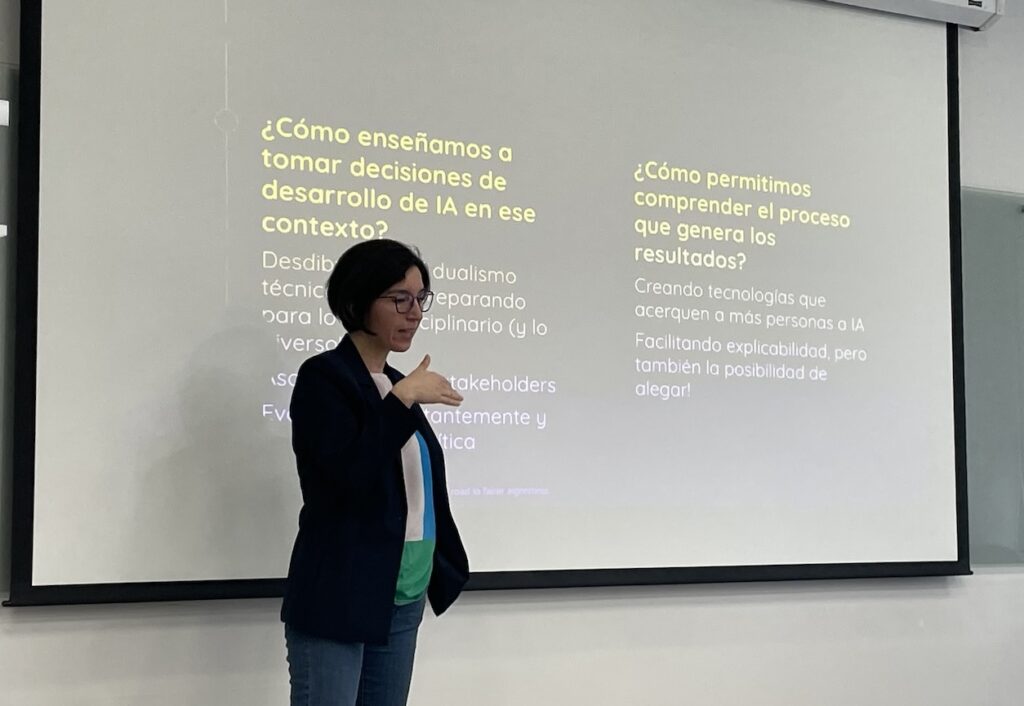

“Mi preocupación es tratar de tener más conciencia de esta situación y generar estudios al respecto en nuestro país. Necesitamos tener mejores metodologías para entender cuándo los sesgos se pueden introducir en nuestros procesos de desarrollo y poder abordarlo de mejor manera, lo que implica aceptar que existen y poner límites a lo que decimos que la IA puede o no hacer. Y, por otro lado, pensar en que la IA es algo que debiéramos trabajar en equipos interdisciplinarios para poder abordar sus implicancias”, explicó López.

En segundo lugar, la IA es una caja negra para las personas usuarias e, incluso, para quienes las desarrollan, es decir, aclaró la docente, no se ve lo que está pasando dentro. “Si decimos, por un lado, que los resultados de la IA son discriminatorios o que no estamos de acuerdo con ellos, pero, además, no sabemos por qué está pasando, tenemos un problema complejo en términos organizacionales y también del desarrollo de nuestra disciplina”, aseguró.

Añadió que “estamos tratando de incluir a las personas para darnos cuenta cómo tenemos agencia en todo este proceso, y con esa agencia podríamos tratar de cambiar el rumbo de los que estamos haciendo con la IA”.

Enfoque centrado en personas para la IA

La profesora López está trabajando en distintos proyectos que buscan entender mejor cómo se puede empoderar a las personas que están involucradas en el flujo de desarrollo de machine learning, de manera de hacerse cargo de cómo las decisiones van a ir influyendo en los efectos de la IA.

“En un trabajo interdisciplinario vamos a poner a disposición del estudio de la tecnología todo lo que sabemos sobre cómo estudiar personas y su relación con la tecnología. Podremos entender así que, conociendo qué pasa con la gente en su relación con la tecnología, se puede ayudar a construir tecnología que obtenga mejores resultados, no sólo de desempeño, sino en las implicancias que podrían tener para las personas”, afirmó.

Uno de los trabajos que está desarrollando Claudia López actualmente se enfoca en estudiar lo que está haciendo una IA en casos específicos, no de manera generalista, sino en un contexto organizacional particular, para conocer sus implicancias y así obtener luces sobre los patrones que se están dando.

Al respecto, aseguró que “una de las decisiones que hemos tomado es considerar la IA en casos particulares, para avanzar en entenderlos y conocer sus implicancias. Y, al mismo tiempo, ir involucrando a personas en las distintas fases de desarrollo de la IA”.

Reflexión ética en la investigación de IA

“Una de nuestras preocupaciones, compartida con otros investigadores, era introducir la reflexión ética dentro del proceso de toma de decisiones en los proyectos de investigación de IA, asumiendo que puede haber impactos negativos”, comentó la académica, quien actualmente está desarrollando una investigación al respecto en el Centro Nacional de Inteligencia Artificial (CENIA).

Explicó que hicieron un diagnóstico y una guía de trabajo para que los proyectos que se están desarrollando en el CENIA incluyan una reflexión ética sobre la base de preguntas específicas sobre los modos en que se están abordando ciertos desafíos y principios éticos, y cómo los están implementado en sus procesos de desarrollo. Estos procesos, puntualizó la investigadora, se someten, además, a una revisión externa.

“Estamos tratando de encontrar y dar pasos metodológicos que permitan a los proyectos en desarrollo incluir la reflexión y ver cómo ello puede cambiar la forma en que hacemos IA”, aseguró la docente.

Objetivos de la ética en IA

La gran diferencia entre los proyectos de investigación en ética que se han llevado a cabo, según señaló López, es que la mayoría de las veces en que se han encontrado implicancias negativas, estas se han detectado una vez finalizado el proyecto. No tiene que ver con los sujetos con los que se prueba el algoritmo, sino con que, una vez que se empieza a usar en otros contextos, aparecen las faltas.

A raíz de esto, su equipo de trabajo se ha planteado tres objetivos en relación con la ética en IA: profundizar el conocimiento sobre los riesgos éticos de la IA y las buenas prácticas; fomentar el análisis con un panel multidisciplinario de los riesgos éticos de los proyectos para la sociedad; y fortalecer el conocimiento técnico disponible para la ciudadanía sobre IA, su potencial y sus riesgos.

Para esto, López está realizando un diagnóstico de ética en el CENIA que busca avanzar hacia soluciones que puedan abordar cuestiones hasta ahora desatendidas.

Entre los principales hallazgos de la investigación, destacan la relevancia transversal que tiene la ética en IA, pero también la carencia de mecanismos y guías para aplicarla. La ética tiende a ser vista negativamente como sinónimo de restricciones y se detectan diferencias en la percepción de su relevancia al propio trabajo; sin embargo, hay veces en que puede que no sea relevante en el trabajo propio, pero sí lo es en el de otros.

“Buscamos invitar a la reflexión y someterla a la revisión por pares interdisciplinares, para luego perfeccionarla. Y así, crear un documento que reporte la reflexión sobre los riesgos identificados y cómo creemos que hay que mitigarlos. Aún no estamos hablando de restricciones, aunque esa puerta no está totalmente cerrada”, concluyó.

Claudia López Moncada

Claudia López Moncada es académica del Departamento de Informática de la Universidad Técnica Federico Santa María (UTFSM), en Valparaíso. Es doctora en Ciencias de la Información y Tecnología por la Universidad de Pittsburgh, Estados Unidos.

Es investigadora asociada del Centro Nacional de Inteligencia Artificial (CENIA) e investigadora principal del Núcleo Milenio de Investigación en Futuros de la Inteligencia Artificial (FAIR). Su trabajo se enfoca en la interacción persona-computador (HCI), la computación social y la IA centrada en personas. Es codirectora del Laboratorio de Experiencia Usuaria de la UTFSM y participa activamente en la comunidad de HCI en América Latina y en iniciativas para aumentar la participación de mujeres en la computación, incluyendo el Encuentro chileno de mujeres en computación (ChileWIC).